Как компьютер обрабатывает информацию

Как компьютер обрабатывает информацию

В древности, когда люди только начинали использовать систему счёта, они, подобно детям, считали на пальцах. У них было десять пальцев, поэтому система счисления стала десятичной. Однако компьютеру ближе двоичная система, потому что у него нет пальцев для десятичного подсчёта.

Компьютер понимает только включено или выключено, сигнал или отсутствие сигнала.

Это обозначается единицей и нулём. Этот язык нулей и единиц называется двоичной системой счисления из-за двух цифр. В нашей десятичной системе нет цифры «10», а в двоичной – нет «2».

Множество других систем счисления существует, например, восьмеричная, пятеричная, шестнадцатиричная.

Каждая система имеет свои особенности, и цифры в них представлены по-разному.

Компьютерные программы часто используют восьмеричную и шестнадцатеричную системы, так как они близки к двоичной и более удобны для компьютера.

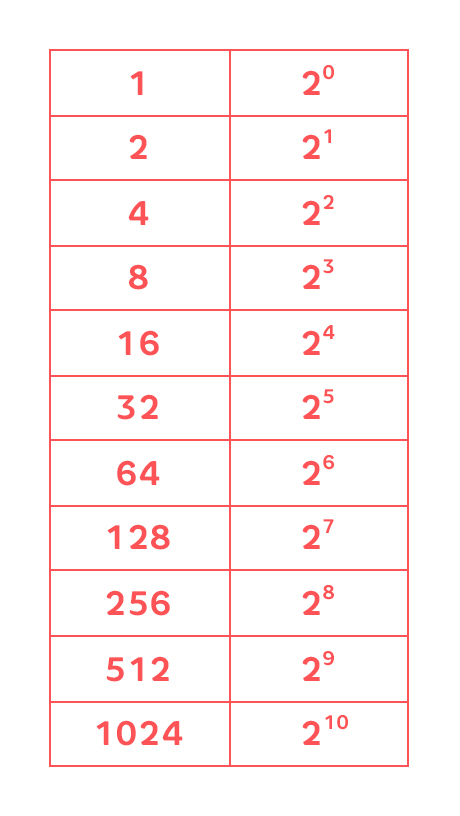

Для перевода чисел из одной системы счисления в другую используются степени чисел. Например, в двоичной системе число 33 записывается как 100001₂.

Кодирование информации в компьютерах является важным аспектом. ASCII была первой кодировкой, а затем появился Unicode, который может закодировать символы разных письменностей. Выбор кодировки зависит от целей использования файла и совместимости с другими устройствами.

Важно сохранять файлы в правильной кодировке, чтобы избежать проблем с расшифровкой текста.

Unicode является рекомендуемой кодировкой для обеспечения совместимости между различными устройствами.

Криптография в информатике не только про тайны, но и имеет практическое применение. Понимание концепций криптографии помогает разбираться в различных аспектах работы с компьютерами и обеспечивает эффективную передачу информации.